\n

\nHola, amigos, bienvenidos al boletín regular de IA de TechCrunch.

\n\nEsta semana en IA, Gartner publicó un informe que sugiere que alrededor de un tercio de los proyectos de IA generativa en empresas serán abandonados después de la fase de prueba de concepto para fines de 2025. Las razones son muchas: mala calidad de los datos, controles de riesgo inadecuados, costos de infraestructura en aumento, etc.

\n\nPero una de las mayores barreras para la adopción de IA generativa es el valor comercial poco claro, según el informe.

\n\nAdoptar IA generativa a nivel organizativo conlleva costos significativos, que van desde los $5 millones a impresionantes $20 millones, estima Gartner. Un asistente de codificación simple tiene un costo inicial entre $100,000 y $200,000 y costos recurrentes de al menos $550 por usuario al año, mientras que una herramienta de búsqueda de documentos impulsada por IA puede costar $1 millón por adelantado y entre $1.3 millones y $11 millones por usuario al año, según revela el informe.

\n\nEstas etiquetas de precio elevadas son difíciles de asimilar para las corporaciones cuando los beneficios son difíciles de cuantificar y podrían tardar años en materializarse, si es que alguna vez lo hacen.

\n\nUna encuesta de Upwork este mes revela que la IA, en lugar de mejorar la productividad, en realidad ha resultado ser una carga para muchos de los trabajadores que la utilizan. Según la encuesta, que entrevistó a 2,500 ejecutivos de nivel C, empleados a tiempo completo y freelancers, casi la mitad (47%) de los trabajadores que utilizan IA dicen que no tienen idea de cómo lograr los aumentos de productividad que esperan sus empleadores, mientras que más de tres cuartos (77%) creen que las herramientas de IA han disminuido la productividad y añadido a su carga de trabajo de al menos una forma.

\n\nParece que la fase de luna de miel de la IA podría estar llegando a su fin, a pesar de la robusta actividad en el lado de capital de riesgo. Y no es sorprendente. Anécdota tras anécdota revela cómo la IA generativa, que tiene problemas técnicos fundamentales sin resolver, a menudo es más problema del que vale la pena.

\n\nJusto el martes, Bloomberg publicó un artículo sobre una herramienta impulsada por Google que utiliza IA para analizar registros médicos de pacientes, ahora en pruebas en hospitales de HCA en Florida. Los usuarios de la herramienta con los que habló Bloomberg dijeron que no puede entregar de manera consistente información confiable sobre la salud; en una ocasión, no pudo notar si un paciente tenía alergias a los medicamentos.

\n\nLas empresas están comenzando a esperar más de la IA. A menos que se produzcan avances en la investigación que aborden lo peor de sus limitaciones, es responsabilidad de los proveedores gestionar las expectativas.

\n\nVeremos si tienen la humildad para hacerlo.

\n\nNoticias

\n\nSearchGPT: OpenAI anunció la semana pasada SearchGPT, una función de búsqueda diseñada para dar respuestas "oportunas" a preguntas, extrayendo información de fuentes web.

\n\nBing suma más IA: No quedándose atrás, Microsoft presentó la semana pasada su propia experiencia de búsqueda impulsada por IA, llamada Bing generative search. Disponible solo para un "pequeño porcentaje" de usuarios en este momento, Bing generative search, al igual que SearchGPT, agrega información de alrededor de la web y genera un resumen en respuesta a consultas de búsqueda.

\n\nX incluye usuarios: X, antes conocido como Twitter, lanzó discretamente un cambio que parece incluir datos de usuario por defecto en su base de entrenamiento para el chatbot Grok de X, un movimiento que fue detectado por usuarios de la plataforma el viernes. Los reguladores de la UE y otros rápidamente protestaron. (¿Te preguntas cómo darte de baja? Aquí tienes una guía).

\n\nLa UE pide ayuda con la IA: La Unión Europea ha iniciado una consulta sobre las reglas que se aplicarán a los proveedores de modelos de IA de propósito general en el marco regulatorio de la UE sobre IA.

\n\nDetalles de licencia de Perplexity: El motor de búsqueda de IA Perplexity pronto comenzará a compartir ingresos publicitarios con editoriales de noticias cuando su chatbot presente su contenido en respuesta a una consulta, un movimiento que parece estar diseñado para calmar a los críticos que han acusado a Perplexity de plagio y web scraping no ético.

\n\nMeta lanza AI Studio: Meta anunció el lunes que está implementando su herramienta AI Studio a todos los creadores en EE. UU. para permitirles crear chatbots personalizados impulsados por IA. La compañía presentó AI Studio por primera vez el año pasado y comenzó a probarlo con determinados creadores en junio.

\n\nEl Departamento de Comercio respalda modelos "abiertos": El Departamento de Comercio de EE. UU. emitió un informe el lunes en apoyo a los modelos de IA generativa "abiertos" como Llama 3.1 de Meta, pero recomendó que el gobierno desarrolle "nuevas capacidades" para monitorear dichos modelos en busca de posibles riesgos.

\n\n$99 Friend: Avi Schiffmann, un desertor de Harvard, está trabajando en un dispositivo AI de $99 llamado Friend. Como su nombre lo indica, el colgante de cuello está diseñado para ser tratado como un compañero de cierto tipo. Pero aún no está claro si funciona tal como se anuncia.

\n\nDocumento de investigación de la semana

\n\nEl aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) es la técnica dominante para garantizar que los modelos de IA generativa sigan instrucciones y cumplan con pautas de seguridad. Pero RLHF requiere reclutar a un gran número de personas para calificar las respuestas de un modelo y proporcionar retroalimentación, un proceso que es largo y costoso.

\n\nAsí que OpenAI está adoptando alternativas.

\n\nEn un nuevo documento, los investigadores de OpenAI describen lo que llaman recompensas basadas en reglas (RBRs), que utilizan un conjunto de reglas paso a paso para evaluar y guiar las respuestas de un modelo. Las RBR desglosan los comportamientos deseados en reglas específicas que luego se utilizan para entrenar un "modelo de recompensa", que guía a la IA —"enseñándole", en cierto sentido— sobre cómo debería comportarse y responder en situaciones específicas.

\n\nOpenAI afirma que los modelos entrenados con RBR demuestran un mejor rendimiento en seguridad que aquellos entrenados solo con retroalimentación humana, al tiempo que reducen la necesidad de grandes cantidades de datos de retroalimentación humana. De hecho, la compañía dice que ha utilizado RBRs como parte de su pila de seguridad desde el lanzamiento de GPT-4 y tiene planeado implementar RBRs en futuros modelos.

\n\nModelo de la semana

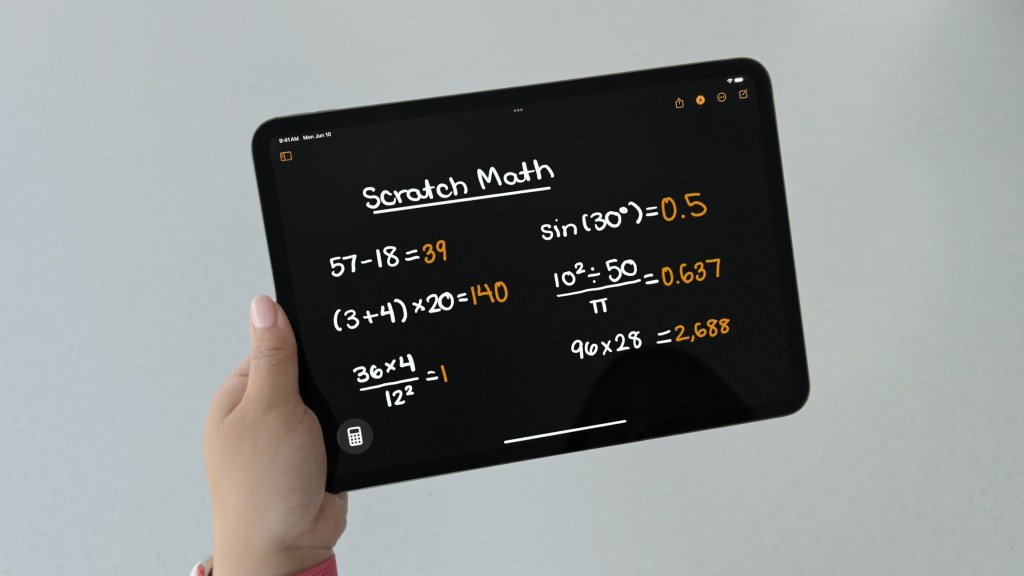

\n\nGoogle's DeepMind está avanzando en su misión de abordar problemas matemáticos complejos con IA.

\n\nHace unos días, DeepMind anunció que entrenó dos sistemas de IA para resolver cuatro de los seis problemas de la Olimpiada Matemática Internacional de este año (IMO), la prestigiosa competencia de matemáticas de secundaria. DeepMind afirma que los sistemas, AlphaProof y AlphaGeometry 2 (el sucesor de AlphaGeometry de enero), demostraron aptitud para formar y aprovechar abstracciones y planificaciones jerárquicas complejas, todo lo cual ha sido históricamente desafiante para los sistemas de IA.

\n\nAlphaProof y AlphaGeometry 2 trabajaron juntos para resolver dos problemas de álgebra y un problema de teoría de números. (Las dos preguntas restantes sobre combinatoria quedaron sin resolver). Los resultados fueron verificados por matemáticos, es la primera vez que los sistemas de IA logran un rendimiento de medalla de plata en preguntas IMO.

\n\nHay algunos matices, sin embargo. Los modelos tardaron días en resolver algunos de los problemas. Y si bien sus capacidades de razonamiento son impresionantes, AlphaProof y AlphaGeometry 2 no necesariamente pueden ayudar con problemas abiertos con muchas soluciones posibles, a diferencia de aquellos con una sola respuesta correcta.

\n\nVeremos qué trae la próxima generación.

\n\nVariedades

\n\nLa startup de IA Stability AI ha lanzado un modelo de IA generativa que convierte un video de un objeto en múltiples clips que parecen haber sido capturados desde diferentes ángulos.

\n\nLlamado Stable Video 4D, el modelo podría tener aplicaciones en el desarrollo de juegos y la edición de video, según Stability, así como en la realidad virtual. "Anticipamos que las empresas adoptarán nuestro modelo, ajustándolo aún más para adaptarlo a sus requisitos únicos", escribió la compañía en una publicación de blog.

\n\n

Para usar Stable Video 4D, los usuarios cargan metraje y especifican los ángulos de cámara deseados. Después de aproximadamente 40 segundos, el modelo genera ocho videos de cinco fotogramas cada uno (aunque la "optimización" puede llevar otros 25 minutos).

\n\nStability dice que está trabajando activamente en refinar el modelo, optimizándolo para manejar una gama más amplia de videos del mundo real más allá de los conjuntos de datos sintéticos actuales en los que fue entrenado. "El potencial de esta tecnología para crear videos realistas de múltiples ángulos es vasto, y estamos emocionados de ver cómo evolucionará con la investigación y desarrollo continuos", continuó la compañía.